- 07-07-2022

- Inteligência Artificial

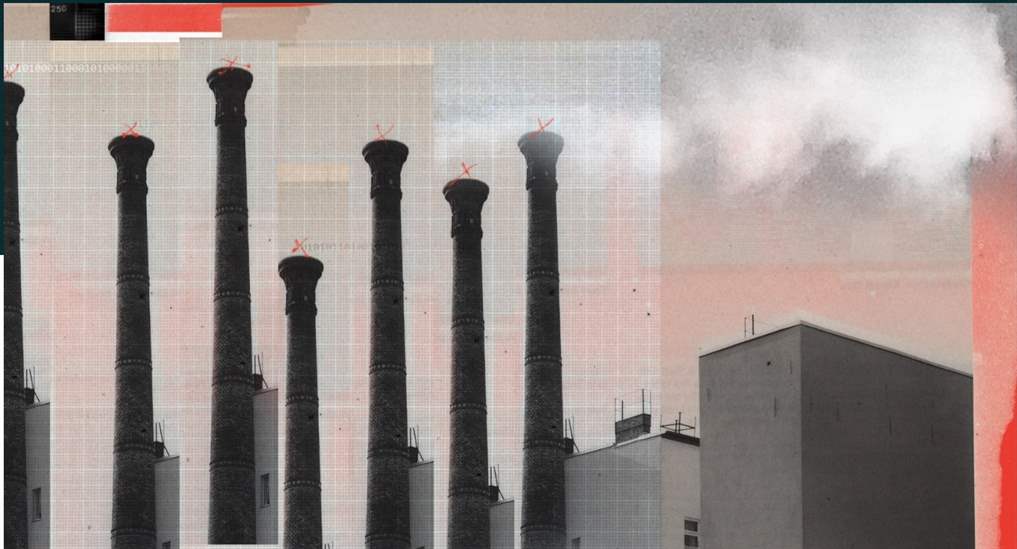

Novas pesquisas mostram como usar algoritmos de DL para uma redução drastica de energia que consomem e as emissões que o trabalho gera. Alterações nas definições de cloud são a chave.

As universidades criaram uma ferramenta que mede o uso de eletricidade de qualquer programa de Machine Learning. Com ele, os utilizadores do Azure que constroem novos modelos podem ver a eletricidade total consumida por unidades de processamento gráficos (GPUs)—de chips especializados na execução de cálculos em paralelo — durante todas as fases do seu projeto, desde a seleção de um modelo até à sua formação e a sua utilização. É o primeiro grande fornecedor de nuvem a dar aos utilizadores acesso a informações sobre o impacto energético dos seus programas de Machine Learning.

A nova ferramenta Azure, que estreou em outubro, reporta atualmente o consumo de energia, não as emissões. Então, agora os investigadores descobriram como mapear o uso de energia para as emissões, e apresentaram artigo sobre esse trabalho na FAccT, uma grande conferência de ciências de computação, no final de junho. Os investigadores usaram um serviço chamado Watttime para estimar as emissões com base nos códigos postais dos servidores em nuvem que executam 11 modelos de Machine Learning.

Eles descobriram que as emissões podem ser significativamente reduzidas se os investigadores usarem servidores em locais geográficos específicos e em determinadas horas do dia. As emissões provenientes do treinamento de pequenos modelos de Machine Learning podem ser reduzidas até 80% se o treino de modelos começar nos momentos em que há mais eletricidade renovável disponível na rede, enquanto as emissões de grandes modelos podem ser reduzidas em mais de 20% se o trabalho de treinamento for interrompido quando a eletricidade renovável é escassa e reiniciada quando é mais abundante.