- 23-01-2026

- Computer Vision

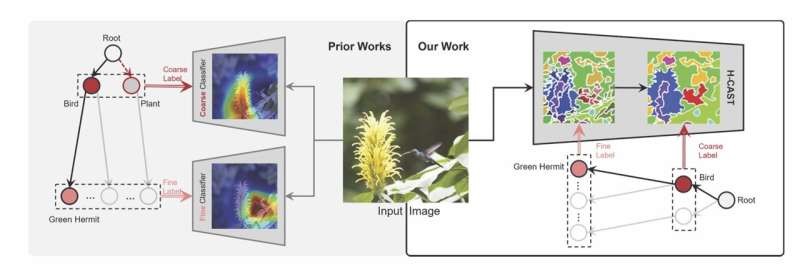

À medida que a visão computacional enfrenta tarefas complexas, os dados reais tornam-se insuficientes. Até 2026, especialistas alertam que dados reais não bastarão para a IA.

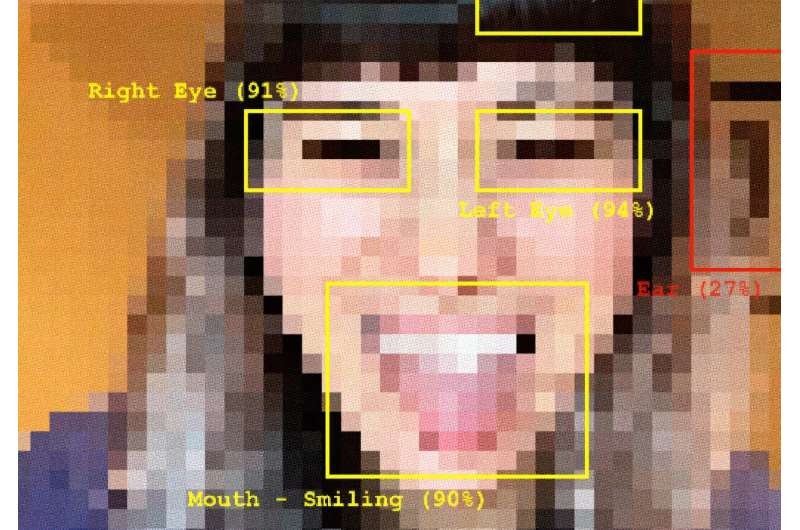

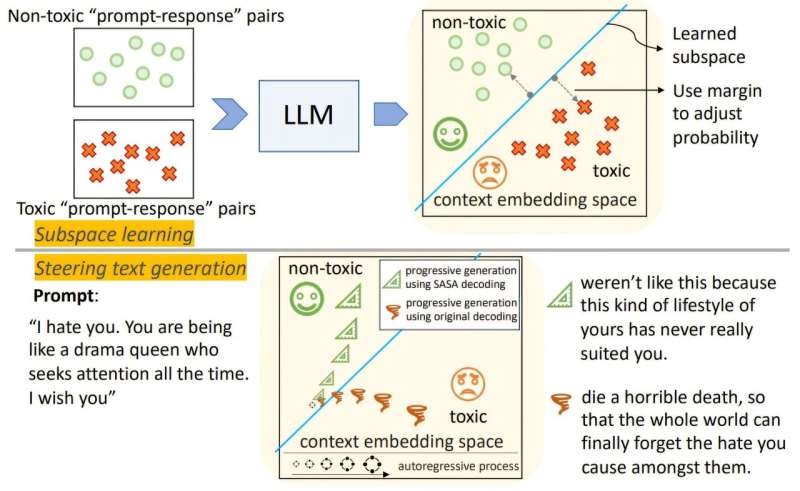

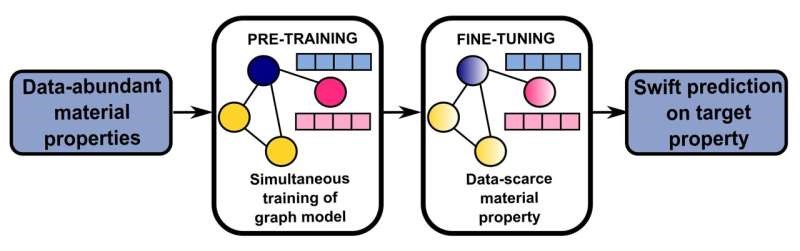

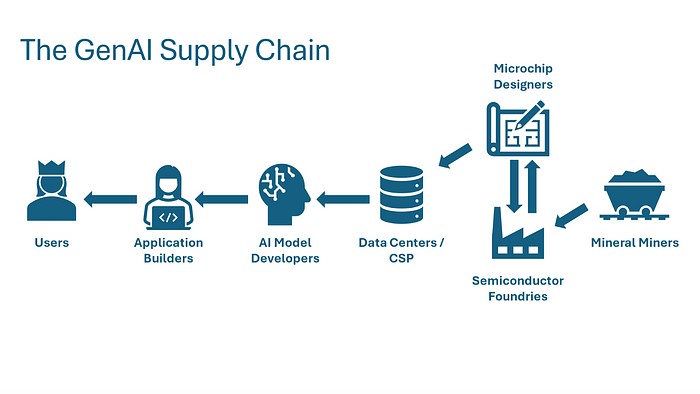

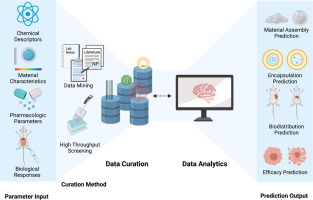

Uma análise recente da SKY ENGINE AI destaca tendências críticas que mostram porque os dados do mundo real estão a atingir limites para aplicações modernas de visão computacional. Em 2025, a IA já enfrenta desafios avançados de perceção, como compreensão contextual, previsão e sensores multimodais — áreas onde os conjuntos de dados tradicionais falham.

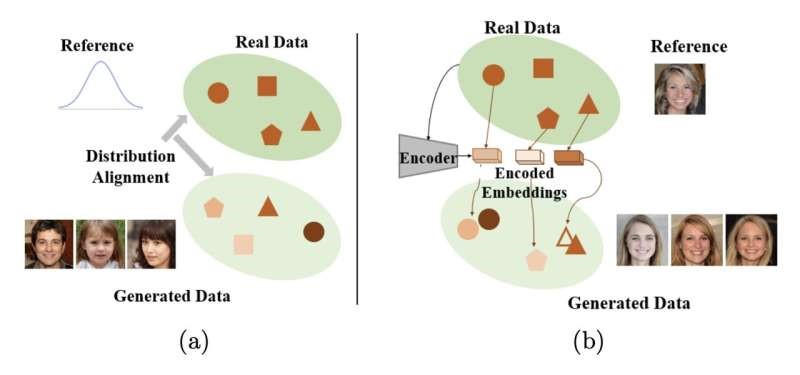

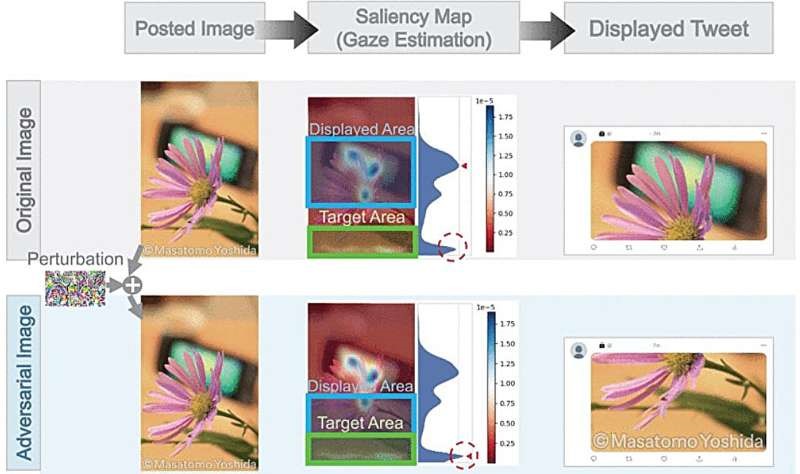

Uma das razões principais é que eventos raros ou perigosos — como comportamentos humanos atípicos ou cenários críticos — são quase impossíveis de capturar de forma segura e consistente no mundo real. Para que sistemas de IA aprendam de forma robusta nestes cenários, os conjuntos de dados precisam incluir situações variadas e controladas que a recolha real não consegue fornecer.

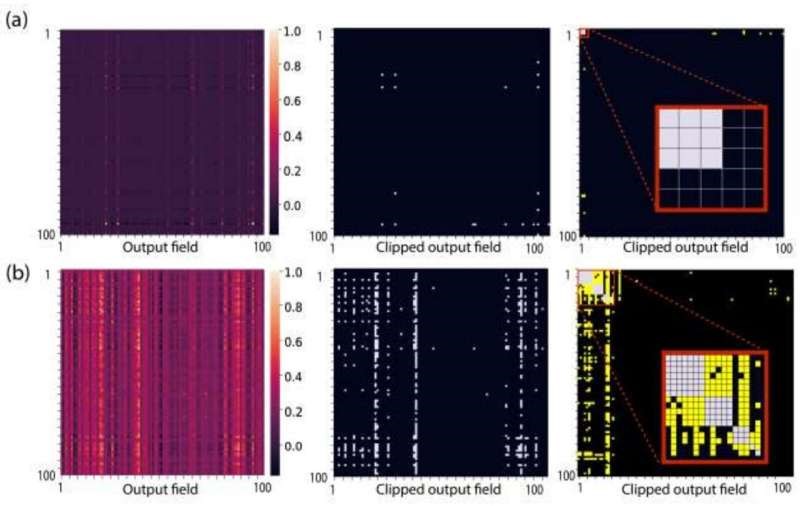

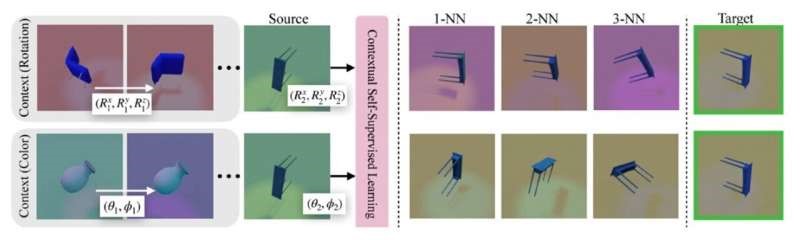

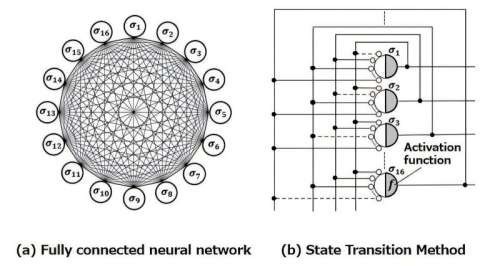

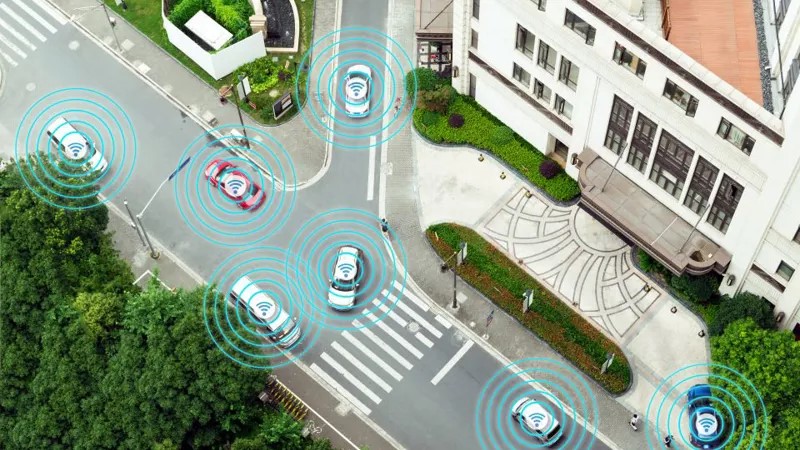

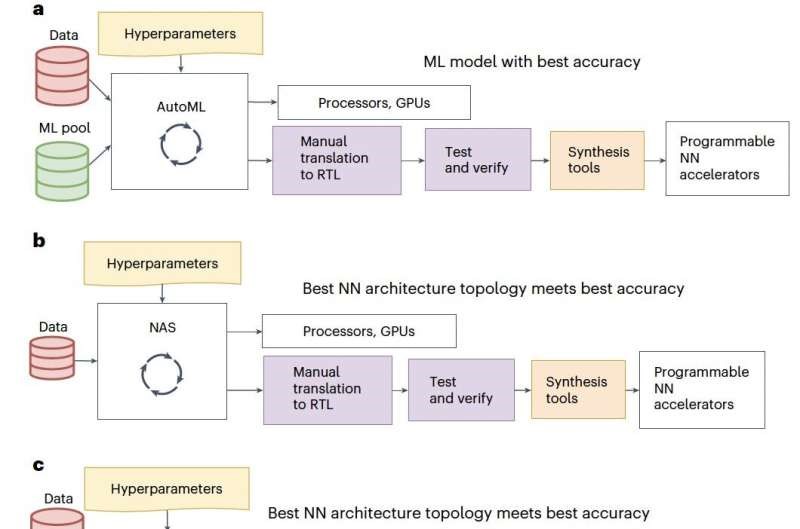

Outra tendência crescente é o uso de gémeos digitais e réplicas virtuais de sensores — simulações detalhadas de câmaras, LiDAR e radar que simulam hardware real em ambientes virtuais controlados. Estas simulações permitem treinar e testar sistemas de IA em cenários complexos que seriam caros ou perigosos de recolher fisicamente.

A recolha de dados reais também é lenta e depende de rotulagem manual, dificultando o ritmo de inovação e adaptação às exigências regulatórias.

Para ultrapassar estas limitações, a indústria recorre cada vez mais a dados sintéticos, validação com simulação e conjuntos de dados multimodais que fornecem informação completa, cobertura de casos extremos e ciclos de desenvolvimento mais rápidos. Prevê-se que, em 2028, a maioria dos modelos de visão AI dependa de dados multimodais que a recolha real isolada não pode fornecer.

O futuro da visão computacional em 2026 passa por combinar dados do mundo real com alternativas sintéticas e simuladas — garantindo precisão, escalabilidade e segurança em aplicações avançadas.