- 16-01-2026

- Artificial Intelligence

Um novo método de investigação transforma modelos de IA opacos em sistemas cujas decisões podem ser interpretadas através de descrições compreensíveis por humanos.

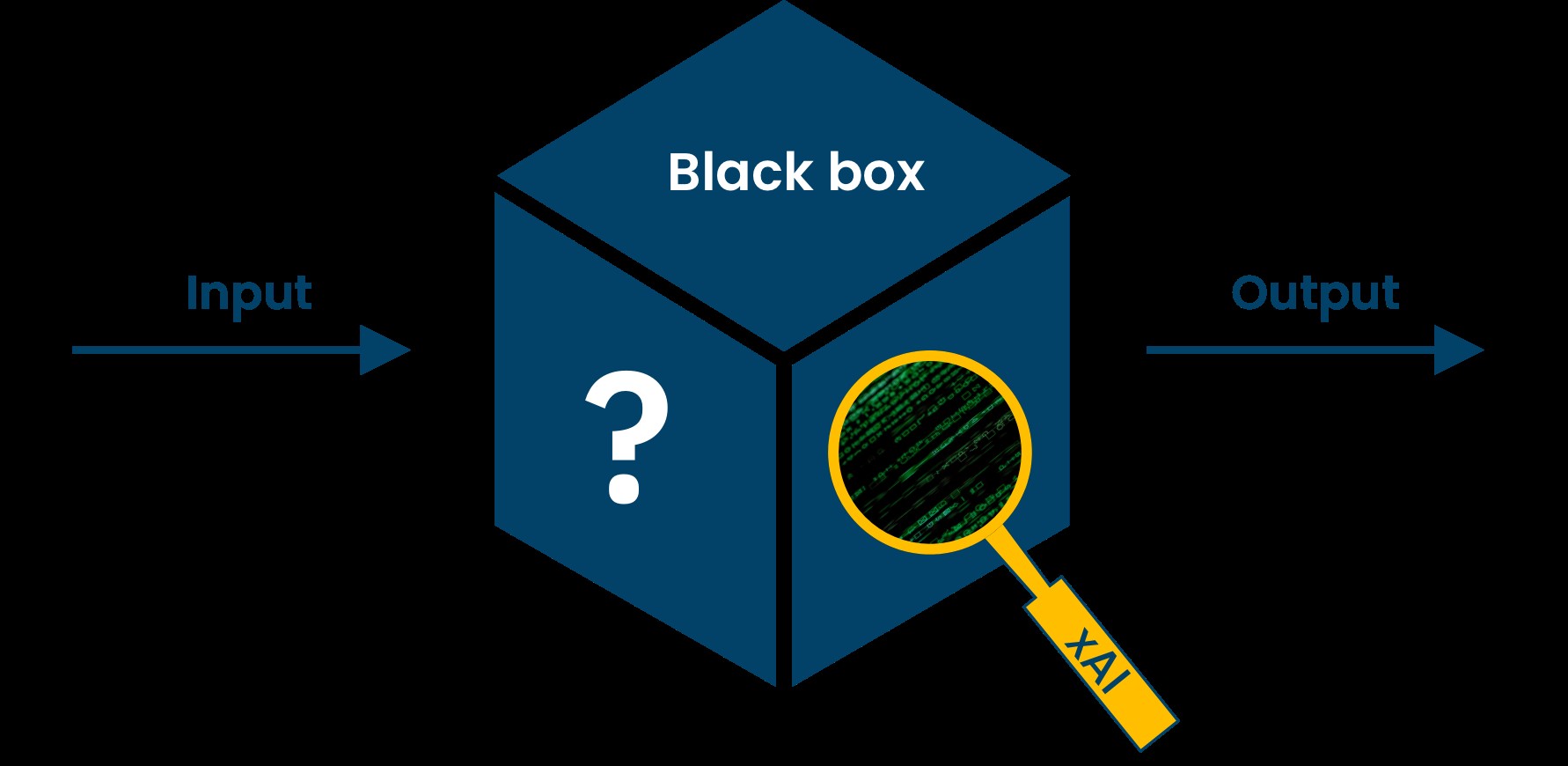

Um estudo recente apresenta uma técnica inovadora para enfrentar um dos maiores desafios da IA: a opacidade dos modelos “caixa-preta”. Embora os sistemas de deep learning sejam muito eficazes no reconhecimento de imagens, raramente explicam por que chegam a determinadas conclusões.

A nova abordagem, desenvolvida na UNIST e divulgada pelo Tech Xplore, concentra-se nos dados de treino. Em vez de analisar apenas as camadas internas do modelo, utiliza grandes modelos de linguagem para gerar descrições detalhadas e humanas das imagens de treino. Estas descrições são avaliadas através de uma métrica inovadora chamada IFT (Influence Scores for Texts), que mede o impacto de cada descrição na precisão do modelo e a sua correspondência com o conteúdo visual.

A técnica permite compreender melhor o que o modelo aprende e como utiliza essa informação, contribuindo para sistemas mais transparentes, seguros e responsáveis.