- 06-12-2024

- AI

Investigadores da Universidade do Texas desenvolveram um modelo de IA inovador que pode converter gravações de áudio em imagens precisas de rua, demonstrando a conexão da IA entre som e visão.

Investigadores da Universidade do Texas em Austin desenvolveram um modelo de IA inovador capaz de converter gravações de áudio em imagens precisas de ruas. A equipe treinou este modelo usa dados emparelhados de áudio e vídeo de várias localizações urbanas e rurais da América do Norte, Ásia e Europa. Eles usaram clipes de áudio de 10 segundos de vídeos do YouTube de diferentes cidades e imagens correspondentes para treinar o modelo, que depois foi capaz de gerar imagens em alta resolução a partir de novos inputs de áudio.

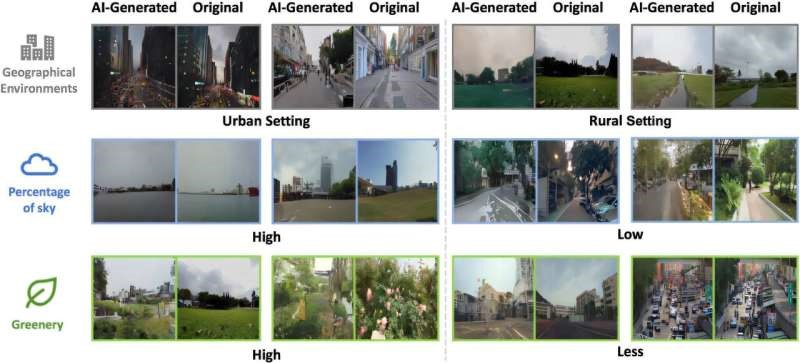

As imagens geradas pela IA mostraram fortes correlações com as imagens do mundo real, em termos das proporções de elementos-chave, como céu, vegetação e edifícios. Juízes humanos conseguiram associar as imagens geradas aos clipes de áudio correspondentes com uma taxa de acerto de 80%. O modelo também manteve os estilos arquitetônicos e o arranjo espacial dos objetos, refletindo a hora do dia com base em sons ambientais, como ruídos de tráfego ou o canto de insetos.

Esta pesquisa demonstra que a IA pode replicar uma habilidade humana de associar som a ambientes visuais, destacando o potencial das máquinas de aproximar-se das experiências sensoriais que os humanos têm ao interagir com seus arredores. O estudo não apenas avança nossa compreensão da capacidade da IA de reconhecer e replicar ambientes físicos, mas também oferece novos insights sobre como fatores multissensoriais influenciam nossa perceção do lugar.